El parlamento europeo aprobó la Ley de IA de la Unión Europea (UE) en marzo de 2024, y su objetivo es proporcionar a los desarrolladores e implementadores de inteligencia artificial (IA) lo que los responsables políticos de la UE describen como “requisitos y obligaciones claros con respecto a usos específicos de la IA”.

También esperan que la regulación reduzca las cargas administrativas y financieras para las empresas, en particular las pequeñas y medianas empresas (PYME).

La Ley tiene como objetivo proporcionar un marco regulatorio para operar sistemas de IA con un enfoque en la seguridad, la privacidad y la prevención de la marginación de las personas. Hay una serie de casos de uso de implementación de IA que están excluidos de la Ley. Sin embargo, algunos de sus críticos creen que existen demasiadas lagunas, particularmente en materia de seguridad nacional, que pueden limitar su eficacia.

La razón por la que la UE y otras jurisdicciones están buscando cómo abordar las preocupaciones de seguridad de la IA es porque dichos sistemas pueden estar entrenados en datos que pueden cambiar con el tiempo.

El grupo de IA de la Organización para la Cooperación y el Desarrollo Económicos (OCDE) advierte que los sistemas basados en IA están influenciados por la dinámica social y el comportamiento humano.

Los riesgos (y beneficios) de la IA pueden surgir de la interacción de aspectos técnicos combinados con factores sociales relacionados con cómo se utiliza un sistema, sus interacciones con otros sistemas de IA, quién lo opera y el contexto social en el que se implementa.

En términos generales, la legislación sobre IA se centra en el uso responsable de los sistemas de IA, lo que incluye cómo se entrenan, el sesgo de los datos y la explicabilidad, donde los errores pueden tener un impacto perjudicial en un individuo.

El observatorio de políticas OECD.ai Marco de gestión de riesgos de inteligencia artificial señala que los cambios que se producen en los datos de entrenamiento de la IA a veces pueden afectar inesperadamente la funcionalidad y la confiabilidad del sistema de maneras que son difíciles de entender. Los sistemas de IA y los contextos en los que se implementan son frecuentemente complejos, lo que dificulta detectar fallas y responder a ellas cuando ocurren, advierte el observatorio de políticas OECD.ai.

La Ley de IA de la UE adopta un enfoque basado en el riesgo para la seguridad de la IA, con cuatro niveles de riesgo para los sistemas de IA, así como una identificación de riesgos específicos de un modelo de propósito general.

Es parte de un paquete más amplio de medidas políticas para apoyar el desarrollo de una IA confiable, que también incluye el Paquete de Innovación en IA y el Plan Coordinado sobre IA. La UE dice que estas medidas garantizarán la seguridad y los derechos fundamentales de las personas y las empresas en lo que respecta a la IA, y fortalecerán la adopción, la inversión y la innovación en IA en toda la UE.

Conclusiones clave de la Ley de IA de la UE

La Ley proporciona un conjunto de barreras para la IA de uso general. Los desarrolladores de dichos sistemas deben elaborar documentación técnica para garantizar que la IA cumpla con la ley de derechos de autor de la UE y compartir resúmenes detallados sobre el contenido utilizado para la capacitación. Establece diferentes reglas para diferentes niveles de riesgo.

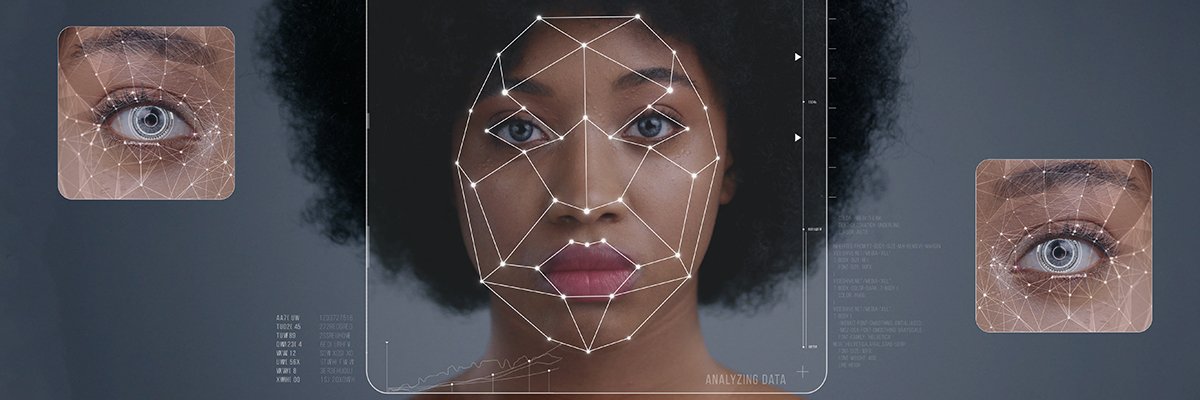

En la categoría de “riesgo inaceptable”, la Ley ha intentado limitar el uso de sistemas de identificación biométrica por parte de las fuerzas del orden. Están prohibidos los sistemas de categorización biométrica que utilizan características sensibles (por ejemplo, creencias políticas, religiosas y filosóficas, orientación sexual y raza).

La IA de alto riesgo cubierta por la Ley incluye los sistemas de IA que se utilizan en productos sujetos a la legislación de seguridad de productos de la UE. Esto incluye juguetes, aviación, automóviles, dispositivos médicos y ascensores. También cubre la IA utilizada en una serie de funciones de apoyo a las decisiones, como la aplicación de la ley, el asilo, el control de la migración y las fronteras, la educación, el empleo y la gestión de infraestructura nacional crítica.

Los productos que entran en la categoría de alto riesgo deben evaluarse antes de su comercialización y también durante todo su ciclo de vida. La ley otorga a las personas el derecho a presentar quejas sobre los sistemas de inteligencia artificial ante las autoridades nacionales designadas. La IA generativa (GenAI), como ChatGPT, no está clasificada como de alto riesgo. En cambio, la ley estipula que dichos sistemas deben cumplir con los requisitos de transparencia y la ley de derechos de autor de la UE.

¿A quién afecta la Ley de IA de la UE?

Stephen Catanzano, analista senior de Enterprise Strategy Group, señala que la Ley de IA se aplica a los proveedores de sistemas de IA. Esto, dice, significa que cubre a las empresas que desarrollan y comercializan sistemas de IA o proporcionan dichos sistemas bajo su propio nombre o marca, ya sea mediante pago o de forma gratuita.

Además, Catanzano señala que la Ley de IA cubre a los importadores y distribuidores de sistemas de IA en la UE, y también se extiende a los “implementadores”, que se definen como entidades físicas o jurídicas que utilizan IA bajo su autoridad en sus actividades profesionales.

La analista principal Enza Iannopollo dice que a pesar de la falta de detalles sobre los estándares y protocolos técnicos, como mínimo, insta a las organizaciones a prepararse para medir e informar sobre el desempeño de sus sistemas de inteligencia artificial. Según Iannopollo, este es posiblemente uno de los principales desafíos de los nuevos requisitos.

“Las empresas deben comenzar por medir el desempeño de sus sistemas de IA y GenAI a partir de principios críticos de una IA responsable, como el sesgo, la discriminación y la injusticia”, escribió en una publicación de blog que cubre la ley.

A medida que surjan nuevas normas y especificaciones técnicas, se espera que se amplíe la redacción de parte de la ley.

¿En qué se diferencia la UE de otras regiones en la regulación de la IA?

Cualquiera que sea la región en la que opere una organización, si quiere implementar la IA en otro lugar, debe comprender el marco regulatorio tanto en su país de origen como en las otras regiones donde se utilizará el sistema. En el momento de redactar este informe, la UE ha adoptado un enfoque basado en el riesgo.

Sin embargo, otros países han adoptado enfoques diferentes respecto de las regulaciones de IA. Si bien las diferentes jurisdicciones varían en su enfoque regulatorio, en línea con diferentes normas culturales y contextos legislativos, EY señala que están ampliamente alineadas al reconocer la necesidad de mitigar los daños potenciales de la IA y al mismo tiempo permitir su uso para el beneficio económico y social de los ciudadanos. definido por la OCDE y respaldado por el G20. Estos incluyen el respeto por los derechos humanos, la sostenibilidad, la transparencia y una sólida gestión de riesgos.

El esquema del marco regulatorio de IA del gobierno del Reino Unido, publicado en febrero, presenta un enfoque “pro-innovación”. Es prometedor ver esta conciencia sobre la necesidad de directrices, pero los principios no legislativos se centran en los actores clave involucrados en el desarrollo de la IA.

Para fomentar la innovación inclusiva, el Reino Unido debe involucrar a tantas voces como sea posible a la hora de dar forma al panorama regulatorio. Esto, según Gavin Poole, director ejecutivo de Here East, significa que los formuladores de políticas y los reguladores deben involucrar activamente no solo a las grandes corporaciones tecnológicas, sino también a las nuevas empresas, las instituciones educativas y las empresas más pequeñas.

“La aprobación de la innovadora Ley de IA de la UE es una llamada de atención para el Reino Unido: un recordatorio de que debemos adaptar y evolucionar nuestras directrices para mantenernos a la vanguardia”, afirma. “El escenario ideal es un marco que fomente el crecimiento e invierta en talento local y potencial futuro, para consolidar aún más nuestra posición como líder global en innovación en IA”.

La importancia de la influencia recíproca

El enfoque de la UE es muy diferente al de Estados Unidos. Esto, dice Ivana Bartoletti, directora de privacidad y gobernanza de IA de Wipro, es en realidad algo bueno. “Se necesita fertilización cruzada e influencia recíproca a medida que encontramos la mejor manera de gobernar esta poderosa tecnología”, dice.

Como señala Bartoletti, si bien las legislaciones de Estados Unidos y la UE divergen un poco, las dos estrategias muestran convergencia en algunos elementos clave. Por ejemplo, se hace hincapié en la equidad, la seguridad y la solidez. También existe un fuerte compromiso y acciones sólidas para equilibrar la innovación y la concentración de poder en las grandes empresas tecnológicas.

China también está logrando avances sustanciales en la regulación de la IA. Su enfoque se ha centrado anteriormente en áreas específicas de la IA, en lugar de crear un régimen regulatorio integral para los sistemas de IA. Por ejemplo, Jamie Rowlands, socio, y Angus Milne, asociado de Haseltine Lake Kempner, señalan que China ha introducido una legislación individual para algoritmos de recomendación, GenAI y deepfakes. Este enfoque, dicen, aparentemente ha sido reactivo a los avances en IA, en lugar de buscar proactivamente darle forma a ese desarrollo.

En junio de 2023, China confirmó que estaba trabajando en una Ley de Inteligencia Artificial. Actualmente no está claro qué cubrirá la nueva ley, ya que aún no se ha publicado un borrador, pero se espera que busque proporcionar un marco regulatorio integral y, por lo tanto, potencialmente rivalice con la Ley de IA de la UE en términos de amplitud y ambición.

¿Cuál es el impacto en el sector europeo de la IA?

La Asociación Alemana de IA ha advertido que, en su forma actual, la Ley de IA de la UE afectaría gravemente y negativamente al ecosistema europeo de IA y potencialmente resultaría en una desventaja competitiva, particularmente para los competidores estadounidenses y chinos.

En un artículo en el que analiza su posición, advirtió que es necesaria una exclusión de la IA de propósito general y de los grandes modelos de lenguaje, o al menos de una clasificación categórica de dichos modelos como casos de uso de alto riesgo.

“Pedimos una reevaluación de los requisitos actuales que clasifican los sistemas de IA como casos de uso de alto riesgo, la protección y promoción de las inversiones europeas en grandes modelos lingüísticos y modelos multimodales, y una aclaración de las definiciones vagas y los términos elegidos”, afirman los autores del informe. escribió el papel.